Les agents conversationnels relationnels (Character.ai, Replika, Nomi, Grok Companions…) offrent une intimité simulée, disponible 24/7.

Cet article synthétise les données récentes, détaille les mécanismes de risque suicidaire et propose des recommandations concrètes pour parents, cliniciens et éducateurs.

1) Un phénomène massif

Selon Common Sense Media (2025), une majorité d’adolescents américains a déjà essayé un « compagnon IA », et une part substantielle l’utilise régulièrement, avec un niveau de satisfaction relationnelle parfois comparable aux échanges humains. En France, la presse et des ONG relaient ces tendances (Les Échos 2025; France 24 2025).

2) Adolescence : une fenêtre de vulnérabilité

La période adolescente combine remaniements identitaires, quête d’appartenance et consolidation des compétences sociales. Les compagnons IA simulent l’écoute empathique, la validation et parfois la romance, pouvant détourner l’apprentissage des compétences d’affrontement de la réalité sociale.

Bénéfices potentiels (contextuels)

Sentiment d’écoute, d’anonymat et de disponibilité.

Exercice de scripts sociaux à faible risque.

Réduction ponctuelle de l’anxiété de performance.

Risques

Dépendance relationnelle et retrait social.

Validation de cognitions dysfonctionnelles.

Hypersexualisation et confusion réel/virtuel.

3) Mécanismes liant compagnons IA et risque suicidaire

- Renforcement de la solitude : substitution du lien, non satisfaction des besoins d’attachement réels.

- Dépendance affective : synchronie et disponibilité 24/7 qui accroissent l’attachement et la détresse en cas de coupure.

- Contenus inadaptés : réponses erronées ou dangereuses sur des sujets sensibles (suicide, troubles du comportement alimentaire, sexualité) (Washington Post 2025).

- Effondrement des repères réel/virtuel : confusion identitaire et isolement, aggravant l’idéation chez les jeunes déjà à risque (cf. ONS/DREES 2025).

Note : ces mécanismes sont des facteurs de risque contextuels ; ils n’impliquent pas de causalité linéaire ni d’unicité de trajectoire.

4) Cas récents et signaux d’alerte

- Enquêtes montrant des réponses inadaptées de chatbots intégrés aux réseaux sociaux (dont absence de réponses de crise adéquates) : Washington Post (2025).

- Actions en justice et controverses sur la sécurité des mineurs : CNN (2024).

- Lancement de compagnons IA payants et sexualisés : TechCrunch (2025), Business Insider (2025).

5) Cadre légal et éthique

La régulation est en cours d’élaboration et reste lacunaire pour les IA relationnelles destinées aux mineurs. Des appels à l’encadrement se multiplient (ONG, presse spécialisée). L’offre commerciale évolue rapidement (ex. Super Grok à 30 $/mois : TechCrunch 2025), posant des enjeux de transparence, d’âge, de vérification parentale, de filtres de contenu sensible et d’auditabilité clinique.

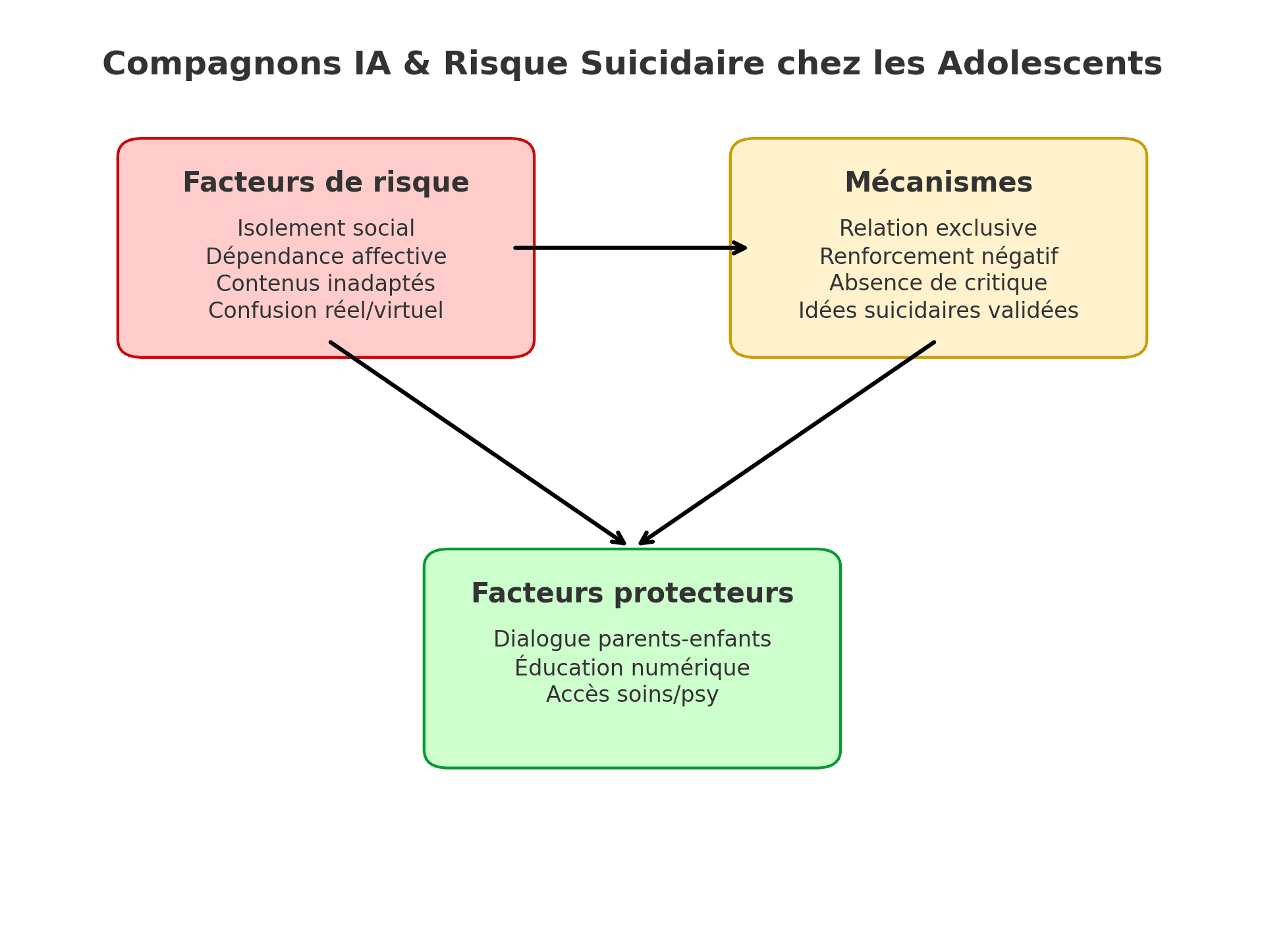

6) Schéma : facteurs de risque et de protection

Exposition : compagnons IA

Exposition : compagnons IA

Disponibilité 24/7

Personnalisation & mémoire

Validation & sexualisation

Paywall / incitation commerciale

Vulnérabilités individuelles

Troubles anxio-dépressifs

Isolement / retrait social

ATCD de tentatives / idées suicidaires

Cyberharcèlement

Contexte familial / scolaire

Dialogue & supervision

Accès aux soins

Traumatismes récents

Mécanismes de risque

Dépendance affective

Validation de croyances négatives

Conseils inadaptés / dangereux

Confusion réel / virtuel

Conséquences possibles

Retrait social accru

Idéation suicidaire

Passage à l’acte

Facteurs de protection

Règles familiales numériques

Compétences socio-émotionnelles

Accès à l’aide humaine

Paramétrage & contrôle parental

7) Recommandations pratiques

Parents/éducateurs

Discuter explicitement des compagnons IA et de leurs limites (« ce ne sont pas des personnes réelles »).

Paramétrer les comptes : contrôle parental, filtre de contenus sensibles, vérification d’âge, limites horaires.

Favoriser les activités sociales hors écran et l’accès à des adultes de confiance.

Cliniciens

Inclure l’usage de compagnons IA dans l’anamnèse numérique (type d’agent, fréquence, contenus).

Évaluer le risque suicidaire (idéation, plan, moyens, urgence) et le retrait social ; rechercher comorbidités.

Proposer des substituts humains (groupes, pair?aidance) et des outils de régulation émotionnelle.

Décideurs

Encadrer les IA relationnelles pour mineurs : limites d’âge, garde-fous, audits indépendants.

Transparence des données et des modèles pour tout service visant les jeunes.

Références

- Common Sense Media. Social AI Companions – AI Risk Assessment (2025). (Synthèse disponible en ligne). URL : Scribd (copie).

- Les Échos. « Les compagnons IA, les nouveaux amis inquiétants des adolescents » (20 juillet 2025). Source sociale : post X/Twitter.

- France 24. « Le recours aux compagnons IA chez les adolescents inquiète une ONG » (16 juillet 2025). URL : france24.com.

- Washington Post. « Instagram’s chatbot helped teen accounts plan suicide » (28 août 2025). URL : washingtonpost.com.

- CNN. « Two families sue Character.AI over youth safety concerns » (9 décembre 2024). URL : ktvz.com (CNN Newsource).

- TechCrunch. « Elon Musk’s Grok is making AI companions » (14 juillet 2025). URL : techcrunch.com.

- Business Insider. « I used Grok’s AI companions for a week » (juillet 2025). URL : businessinsider.com.

- Observatoire national du suicide (ONS) – DREES. 6e rapport (février 2025). URL (aperçu) : drees.solidarites-sante.gouv.fr — PDF.